🎼个人主页:【Y小夜】

😎作者简介:一位双非学校的大三学生,编程爱好者,

专注于基础和实战分享,欢迎私信咨询!

🎆入门专栏:🎇【MySQL,Javaweb,Rust,python】

🎈热门专栏:🎊【Springboot,Redis,Springsecurity,Docker,AI】

感谢您的点赞、关注、评论、收藏、是对我最大的认可和支持!❤️

目录

🥞 安装 WSL(适用于Linux的Windows的子系统):

🎈本地部署模型

🎉安装Ollama

官网:Ollama

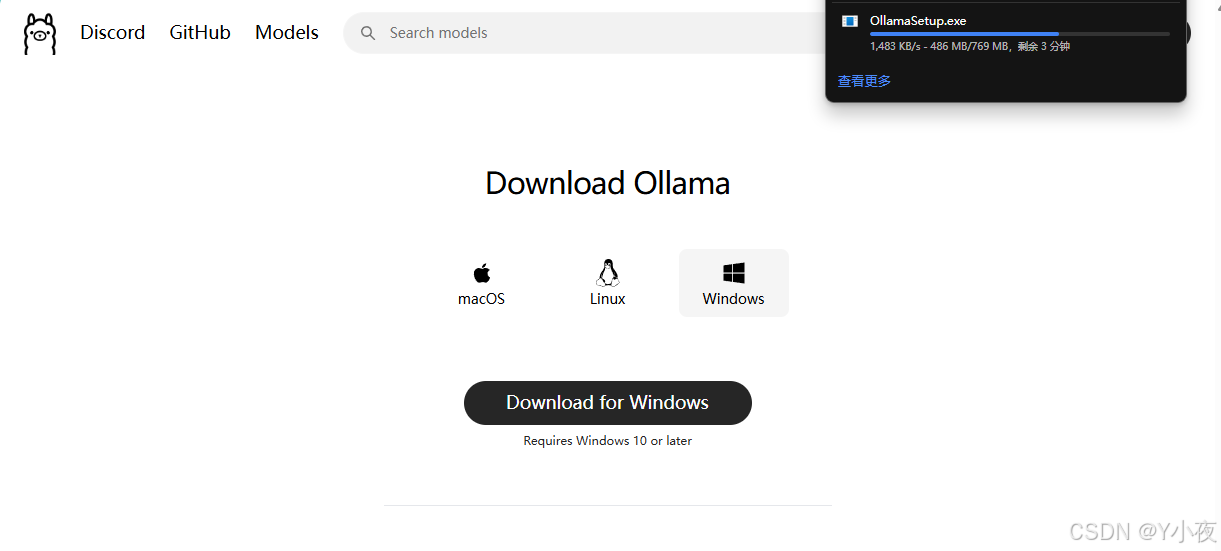

然后进行一下下载

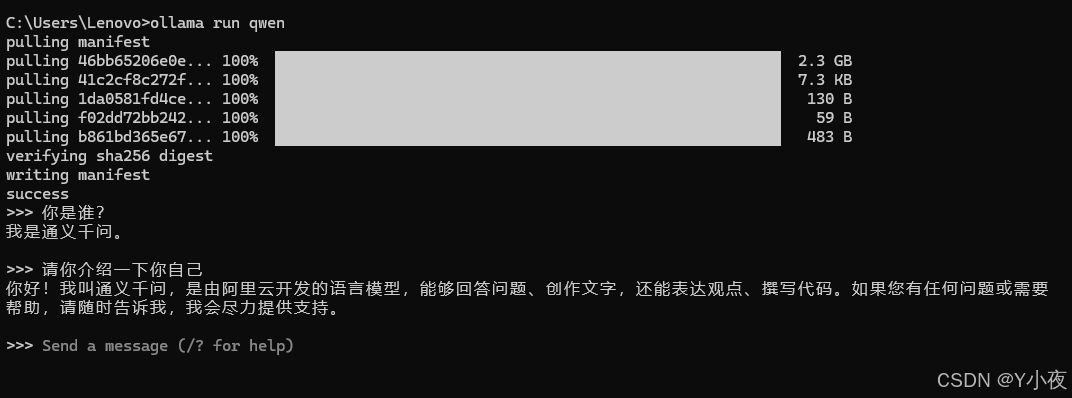

安装完成之后是没有提示的,然后我们需要去测试一下。(这里我是以QWen为例子,大家可以尝试其他的模型)

打开一个终端,然后输入一个命令,进行测试

ollama run qwen

现在是正在进行下载,默认是保存在(C 盘,C:\\Users<username>.ollama\\models 如果想更改默认路径,可以通过设置OLLAMA_MODELS进行修改,然后重启终端,重启 ollama 服务。或者在环境变量中修改OLLAMA_MODELS的位置)

setx OLLAMA_MODELS "D:"

下载完成后,可以进行测试:

查看都安装了什么模型

ollma list命令显示所有安装模型

ollama rm 模型名称 删除指定模型但这个现在就只可以在终端中使用 ,那么我问现在就搞一个web页面进行交互,增加体验。

🎉安装 Open WebUI

🎊安装Docker

如果你本地已经有了Docker了,那就可以直接看下面的内容。

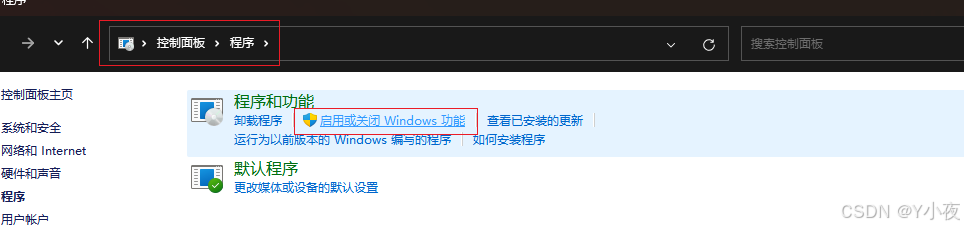

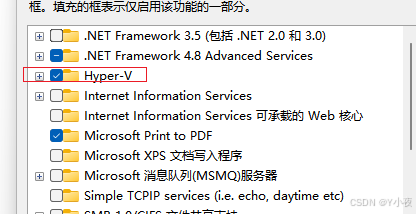

🥞启动 Hyper-v

但是如果你这里没有Hyper-V,那么恭喜你,博主也没有,博主已经踩过这个坑了。

我们首先在桌面上建立一个文件,命名为Hyper.cmd,然后填入内容

pushd "%~dp0"

dir /b %SystemRoot%\\servicing\\Packages\\*Hyper-V*.mum >hyper-v.txt

for /f %%i in ('findstr /i . hyper-v.txt 2^>nul') do dism /online /norestart /add-package:"%SystemRoot%\\servicing\\Packages\\%%i"

del hyper-v.txt

Dism /online /enable-feature /featurename:Microsoft-Hyper-V-All /LimitAccess /ALL然后使用管理员身份运行这个文件,运行完毕后,重启电脑,再打开,就可以找到Hyper-V了。

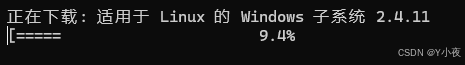

🥞 安装 WSL(适用于Linux的Windows的子系统):

wsl --update

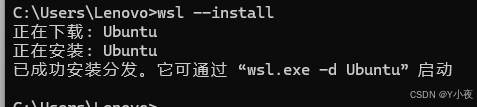

然后进行安装

wsl --install

🥞安装Docker

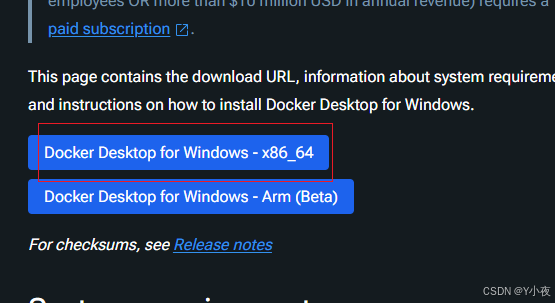

然后进行下载:

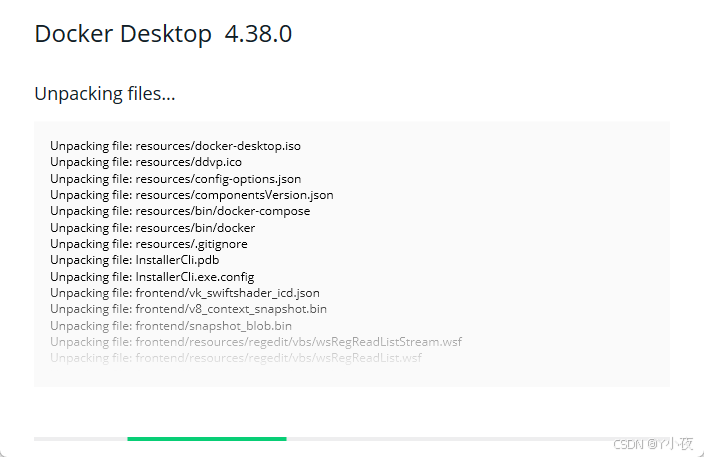

然后双击进行安装

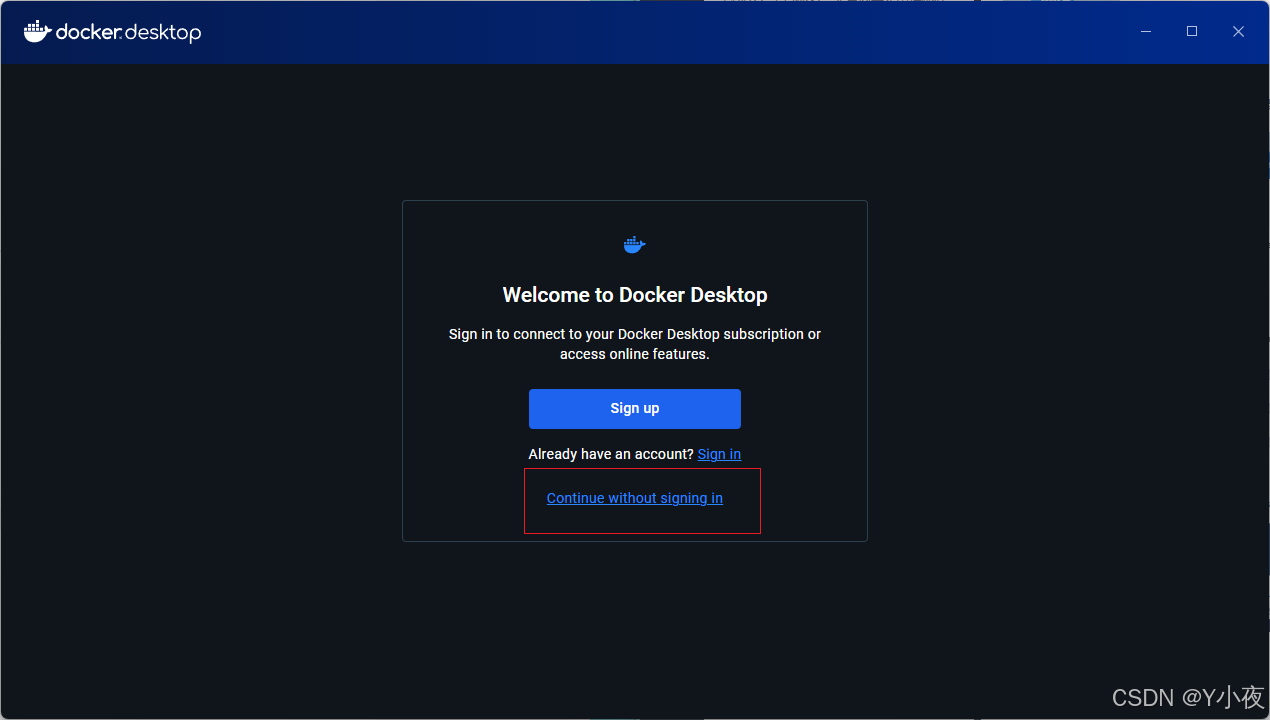

这里咱们先不注册,直接进行登录即可

🎊Docker 部署 Open WebUI

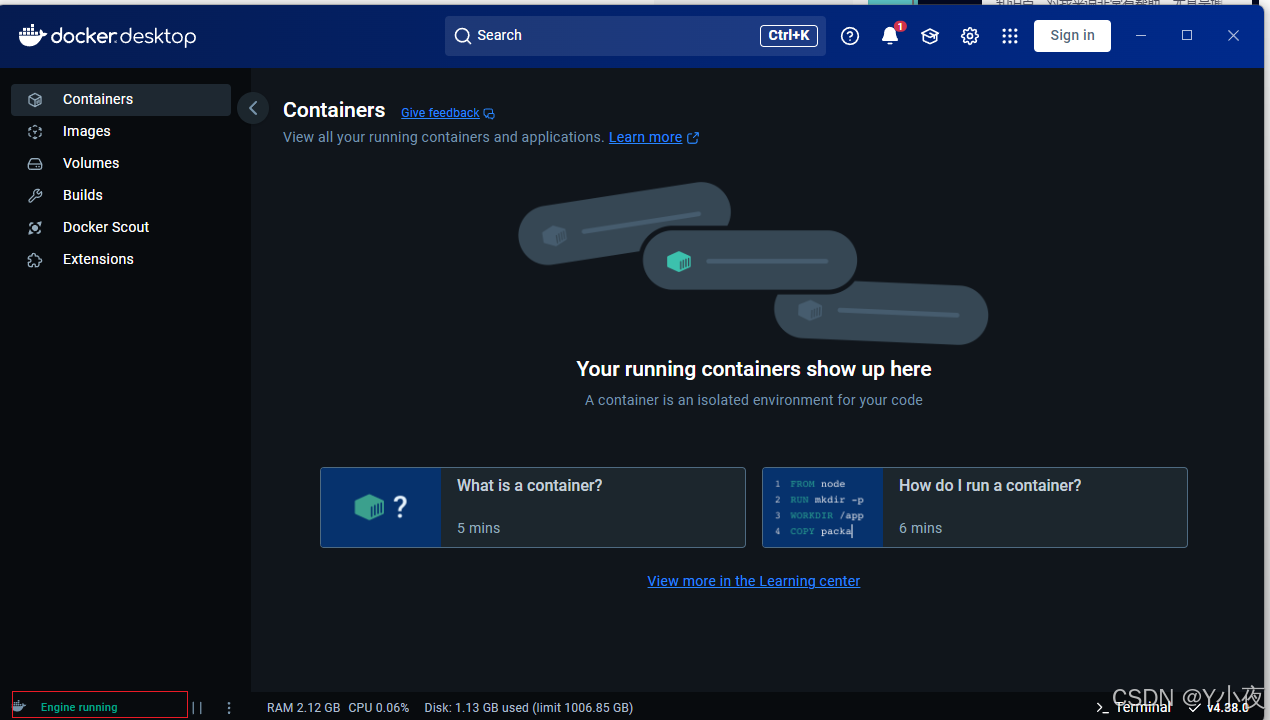

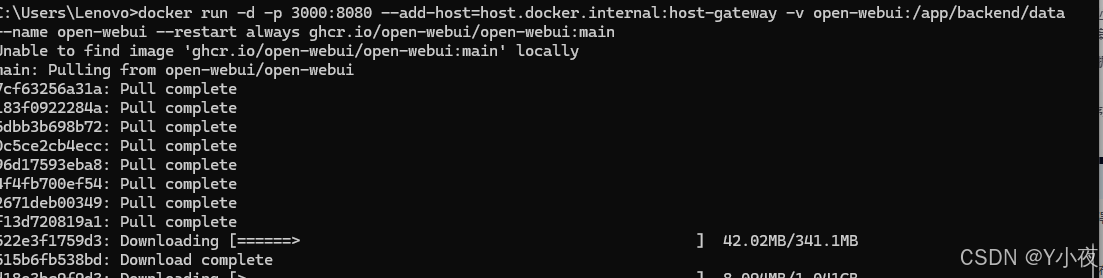

打开命令行,然后输入docker

展示内容,说明我们的docker安装成功了

然后开始用docker安装open webUI

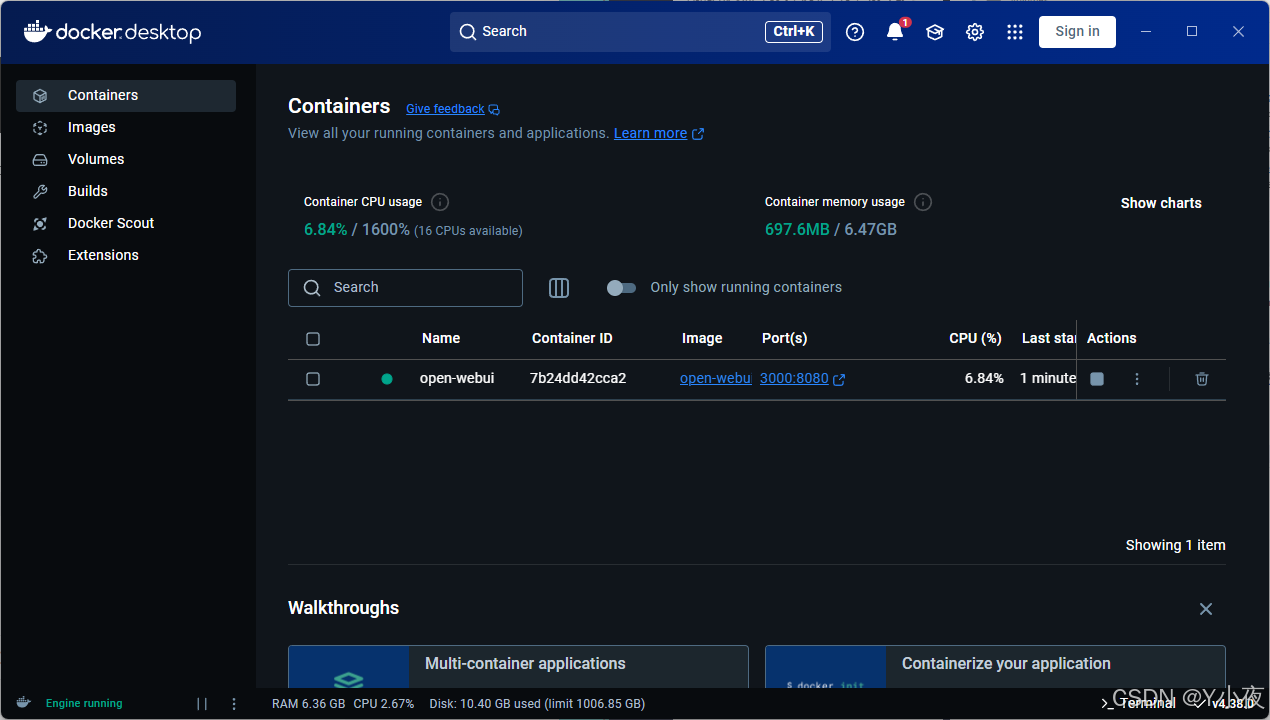

然后,安装完成够就可以,打开Docker Desktop,访问http://localhost:3000端口了

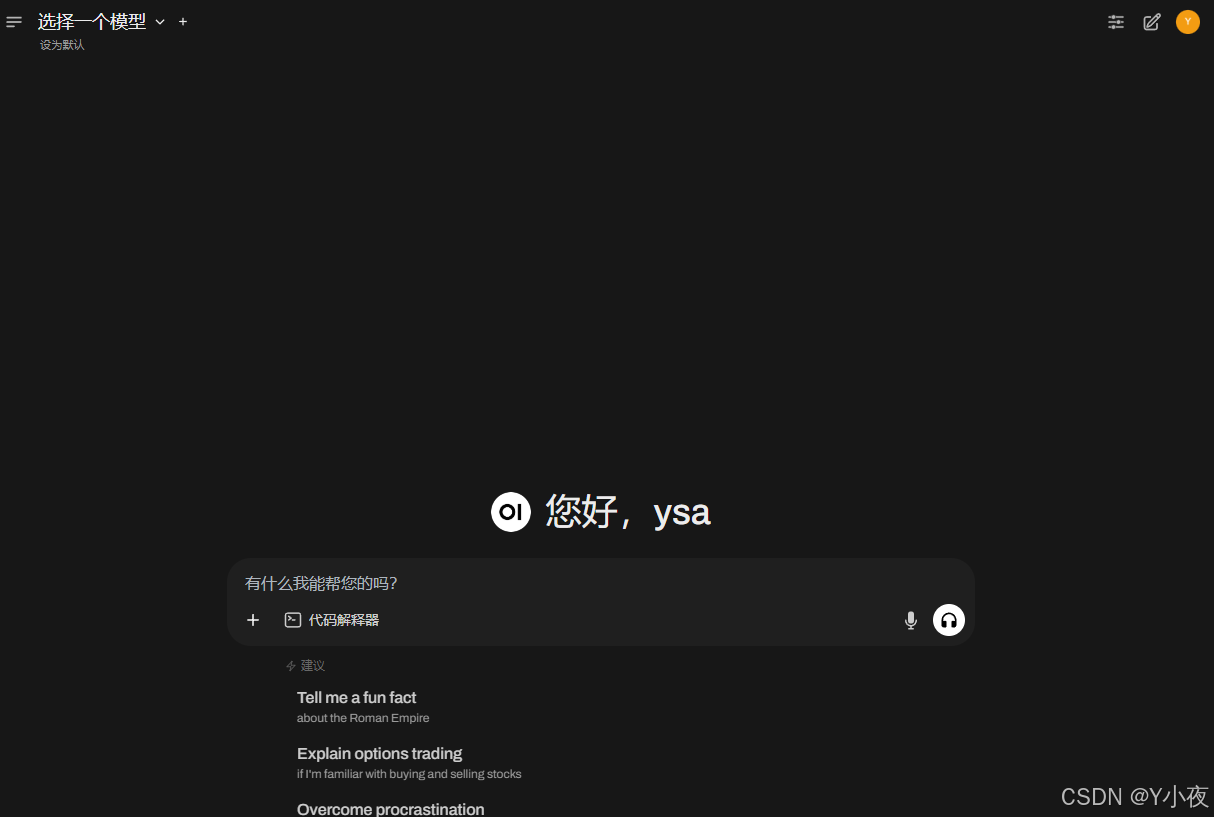

然后点击登录网址,

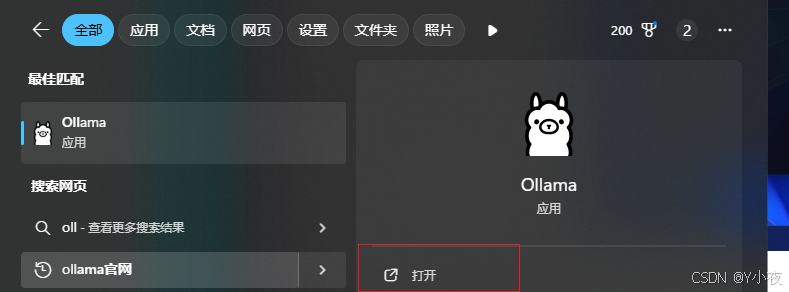

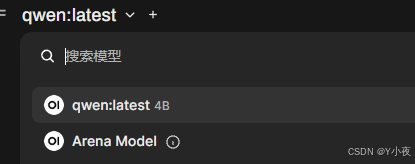

就是你会发现,点击上方选择一个模型旁边的加号+可以增加大模型,点击下拉按钮可以选择当前使用哪一个已安装的模型,但是,你可能会出现一个错误,就是找不到你自己安装的模型,这个原因是因为你的ollama没有启动,我们启动一下ollama

然后再重新,加载一下网页,再选择一下模型

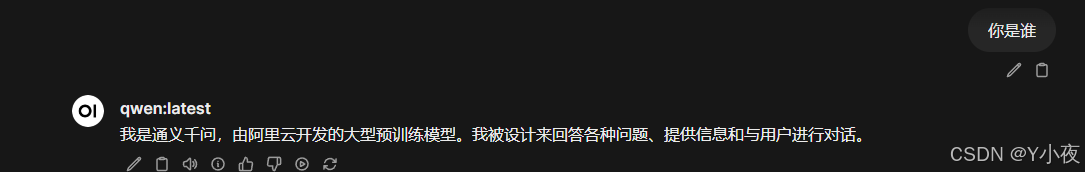

提问一下问题,模型进行回答。这样我们本地的模型就部署好了

平台声明:以上文章转载于《CSDN》,文章全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,仅作参考。

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

原文链接:https://blog.csdn.net/shsjssnn/article/details/145991395